Das Problem mit KI-Feedback

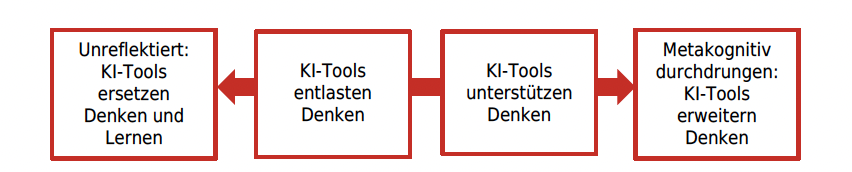

In der Diskussion über den lernförderlichen Einsatz von KI gibt es einen Konsens: KI-Tools sollten so eingesetzt werden, dass wir uns in der Abbildung von Isabella Buck möglichst weit rechts befinden.

Dabei setzt sich eine Sichtweise immer stärker durch: Im Idealfall würden KI-Tools benutzt, um Feedback zu generieren. Dann würden sie Denk- oder Lernprozesse unterstützen und Lernenden Möglichkeiten geben, die sie ohne diese Tools nicht hätten.

Diese Sichtweise halte ich in dieser grundsätzlichen Form für problematisch. Weshalb, werde ich im Folgenden begründen.

Was ist (gutes) Feedback?

Lernförderliches Feedback hat folgende wesentlichen Merkmale (Quellen und weitere Hinweise findet man hier):

- Feedback ist Teil von Beziehungsarbeit und grundsätzlich erbeten oder erwünscht.

- Es nimmt den Lernenden das Denken nicht ab und richtet sich auf das, was sie schon teilweise verstanden haben.

- Feedback hilft, beabsichtigte Lernprozesse durch spezifische Informationen zu verbessern.

- Feedback begrenzt die korrektiven Information so, dass die Lernenden damit umgehen können.

- Feedback ist sachlich richtig.

- Feedback berücksichtigt den systemischen Kontext, in dem eine Lernerfahrung stattfindet.

Wenn wir diese Merkmale durchgehen, merken wir sofort: Ein KI-Tool kann kein Feedback von dieser Qualität hervorbringen, weil es weder in Beziehungsarbeit noch in Kontexte eingebunden ist. Kein automatisiertes Feedback-Werkzeug versteht, was Lernende geleistet haben, wie sie sich verbessern können. Es betreibt Mustererkennung und kann diese Muster fortsetzen. Die Einsichten zur Funktionsweise von Feedback besagen aber gerade, dass es nicht darum geht, Lernenden zu zeigen, wie es richtig ginge. Vielmehr geht es darum, ihre Anstrengungen mit sehr dosierten Informationen gleichzeitig zu würdigen und eine mögliche Verbesserung einfacher zu machen.

Damit KI-Tools das leisten können, müssen Menschen sie bewusst so einsetzen, programmieren, einschränken und anpassen. Es kann durchaus hilfreich sein, zu erfahren, wie eine Maschine einen Text oder eine Arbeit beurteilt. In der Regel ist das aber kein wirksames Feedback.

Der politische Rahmen von Bildung: KI als Sparprogramm

KI-Tools werden Lehrer:innen damit schmackhaft gemacht, dass sie Zeit sparen können bzw. Schüler:innen viel mehr Rückmeldungen erhalten würden, als das durch menschliche Arbeit möglich ist. Das klingt auf den ersten Blick einleuchtend, ist es aber aus zwei Gründen nicht: Erstens, das hat der letzte Abschnitt gezeigt, ist mehr Feedback nicht besseres Feedback. Zweitens stopfen diese Tools eine Lücke, welche politisch aufgerissen wird. Schlechte Betreuungsverhältnisse und das Kaputtsparen von Bildungsgängen können nicht mit KI-Hilfsmitteln kompensiert werden (diese Hoffnung hat sich schon bei der Computerisierung, bei Lernvideos, bei Lernplattformen etc. zerschlagen, hier wiederholt sich die Geschichte laufend).

Axel Krommer hat die wesentlichen Gedanken dazu treffend zusammengefasst:

Bender und Hanna fassen in einem Satz zusammen, warum KI-Tools (in der Regel) keine nachhaltigen Lösungen, sondern Symptome einer Krise sind und warum der bildungspolitische Techno-Solutionismus in eine Sackgasse führt: „Text synthesis machines can’t fill holes in the social fabric. We need people, political will, and resources.” (Bender/Hanna 2025, S. 99)

Es steht zu befürchten, dass es aktuell an Menschen, politischem Willen und Ressourcen mangelt, um drängende Probleme im Bildungssystem nicht nur auf der Oberfläche, sondern in struktureller Tiefe angemessen anzugehen. Zu verlockend, kostengünstig und schlagzeilenträchtig ist es für politische Entscheidungsträger:innen, getragen vom KI-Hype überall Nägel zu sehen, die man mit dem KI-Hammer einschlagen kann.

Das ist besonders für diejenigen frustrierend, die in der (hoch-)schulischen Praxis tatsächlich versuchen, KI-Technologie innovativ und disruptiv zu nutzen.

Die mangelnde Qualität

Claudia Potthoff hat vor fast zwei Jahren die damals verfügbaren Anwendungen mit Schüler:innen getestet und in einem Blogpost folgende Ergebnisse formuliert:

Alle getesteten KI-basierten Anwendungen

…geben ein Feedback, das besser als keine Resonanz ist,

…sind grundsätzlich geeignet, um eine Rückmeldung zur eingegebenen Schülerlösung zu erhalten. Das Feedback enthält keine gravierenden Fehler (übersieht jedoch Fehler), ist angemessen, meistens verständlich und überwiegend nachvollziehbar, unvollständig,

…sind tendenziell oberflächlich, d. h. verweisen nicht auf zu verbessernde oder besonders gelungene Passagen (Negativ-, Positivkorrektur),

…sind unspezifisch, da sie keinerlei konkrete inhaltliche Verbesserungsvorschläge beinhalten oder auf konkrete inhaltliche Vorzüge eingehen,

…erkennen offensichtlichen Nonsens nicht.

Auch verbesserte Versionen der Tools oder Modelle entkommen diesen Problemen nicht. KI-Tools geben kein Feedback, sondern sie erzeugen einen Feedback-Text. Egal wie sie eingebunden oder programmiert werden, entkommen sie diesem Problem nicht. Problematisch ist das, weil Schüler:innen nicht erkennen können, wo Qualitätsprobleme liegen. Die Frage, ob dieses Feedback wirklich besser als keine Resonanz ist, würde ich so mal zur Diskussion stellen.

Die Affordanz

KI-Feedback wird primär in der Schreibdidaktik eingesetzt, wenn es darum geht, dass Schüler:innen Texte hervorbringen und diese verbessern müssen. Dabei entstehen Paradoxien, welche die Wirksamkeit dieser Rückmeldetools durchaus beeinflussen:

- Je mehr Kriterien formuliert werden, desto präziser wird das KI-Feedback: die KI kann also primär bei Texten helfen, die ganz spezifischen Kriterien genügen müssen.

- Texte, deren Eigenschaften über Kriterien festgelegt sind, können KI-Systeme am besten hervorbringen.

- Schüler:innen müssen diese Texte in Prüfungskontexten schreiben, in denen sie KI-Tools nicht verwenden dürfen.

- Sie nutzen also Tools, welche das, was sie machen müssen, besser können als sie selber, dürfen aber von diesen Tools nur Feedback erhalten, mit dem sie dann das simulieren sollen, was Maschinen besonders gut können.

Konstruktive Perspektiven auf die Nutzung von KI

KI kann die pädagogische Beziehungsarbeit nicht ersetzen, weil nur Menschen beurteilen können, in welchen Kontexten Lernprozesse stattfinden. Grundsätzlich können nur Menschen Feedback geben. Der Einsatz von KI-Tools verändert möglicherweise unser Verständnis von Feedback und wandelt es hin zu einer Art automatisierten Reaktion durch einen Text. Das ist aber nicht, was Feedback sein sollte.

Dennoch gibt es ein paar sinnvolle Szenarien, wie KI eingesetzt werden kann. Dabei möchte ich mich nicht an künstlichen Prüfungsszenarien festhalten, weil diese als Argument von Unternehmen missbraucht werden, die von der problematischen Prüfungskultur profitieren, indem sie die Wirksamkeit von KI-Feedback übertrieben darstellen.

Grundsätze von wirksamem KI-Feedback sind:

- Lernende wünschen sich eine automatisierte Rückmeldung auf ein Lernprodukt (z.B. eine Korrektur formaler Fehler).

- Lernende können die Rückmeldung verstehen, sie haben ein tiefes Verständnis für die Funktionsweise von KI-Tools.

- Lernende haben genügend Freiheit, um eigene Entscheidungen zu treffen, bei denen sie anhand von KI-Feedback Sicherheit gewinnen.

- Lernende arbeiten nicht an Produkten, welche die KI direkt besser hervorbringen könnte.